B站的弹幕区一直是人才圣地。今天我就用 python 来手把手教大家爬取B站排行榜热门视频,Python爬取视频也可以如此简单。

网站分析

在B站中,只要视频中有弹幕,就会有一个 cid 参数。cid 用来表示某个视频对应的弹幕池。每个弹幕都有一个对应的 XML 文件,我们可以通过解析 XML 文件获取到 B 站视频的弹幕。

所以,只要知道了 cid 参数值,就可以找到视频弹幕数据的位置了。

那我们在观看视频的时候该如何拿到这个 XML 文件呢?

B 站的弹幕是在 XML 文件里,每个视频都有其对应的 cid 和 aid,我们取到 cid 中的数字放入

http://comment.bilibili.com/cid.xml,即可得到该视频对应的弹幕 XML 文件。

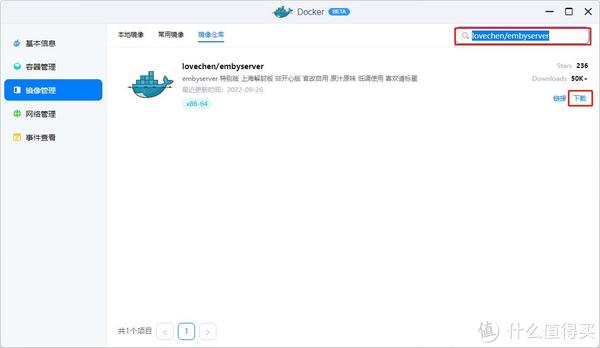

首先我们打开视频播放地址,F12打开浏览器开发者模式,如下图找到视频对应的cid就可以构造出弹幕链接

http://comment.bilibili.com/451236101.xml

到此可为止,有了弹幕文件,后面将通过爬虫方式解析弹幕,并进行弹幕内容分析。

请求发送

我们使用request模拟浏览器发送请求获取弹幕数据

url = fhttp://comment.bilibili.com/{

cid}.xml

headers = {

referer: https://www.bilibili.com/video/BV19h411s7oq?spm_id_from=333.934.0.0,

User-Agent: https://www.bilibili.com/video/BV19h411s7oq?spm_id_from=333.934.0.0,

cookie: “_uuid=19DF1EDB-20B7-FF74-A700-9DF415B2429530977infoc; buvid3=AAD6C6C7-FB31-40E7-92EC-7A6A7ED3920C148814infoc; sid=jzp2723t; fingerprint=2e74a5bc11a3adec2616987dde475370; buvid_fp=AAD6C6C7-FB31-40E7-92EC-7A6A7ED3920C148814infoc; buvid_fp_plain=AAD6C6C7-FB31-40E7-92EC-7A6A7ED3920C148814infoc; DedeUserID=434541726; DedeUserID__ckMd5=448fda6ab5098e5e; SESSDATA=1fe46ad7%2C1651971297%2Ceb583*b1; bili_jct=5bcd45718996ac402a29c7f23110984d; blackside_state=1; rpdid=|(u)YJlJmmu|0JuYJYRummJm; bp_t_offset_434541726=590903773845625600; bp_video_offset_434541726=590903773845625600; CURRENT_BLACKGAP=0; LIVE_BUVID=AUTO5716377130871212; video_page_version=v_old_home; PVID=1; CURRENT_FNVAL=976; i-wanna-go-back=1; b_ut=6; b_lsid=4F7CFC82_17D78864851; bsource=search_baidu; innersign=1”

}

resp = requests.get(url, headers = headers)

print(resp.text)

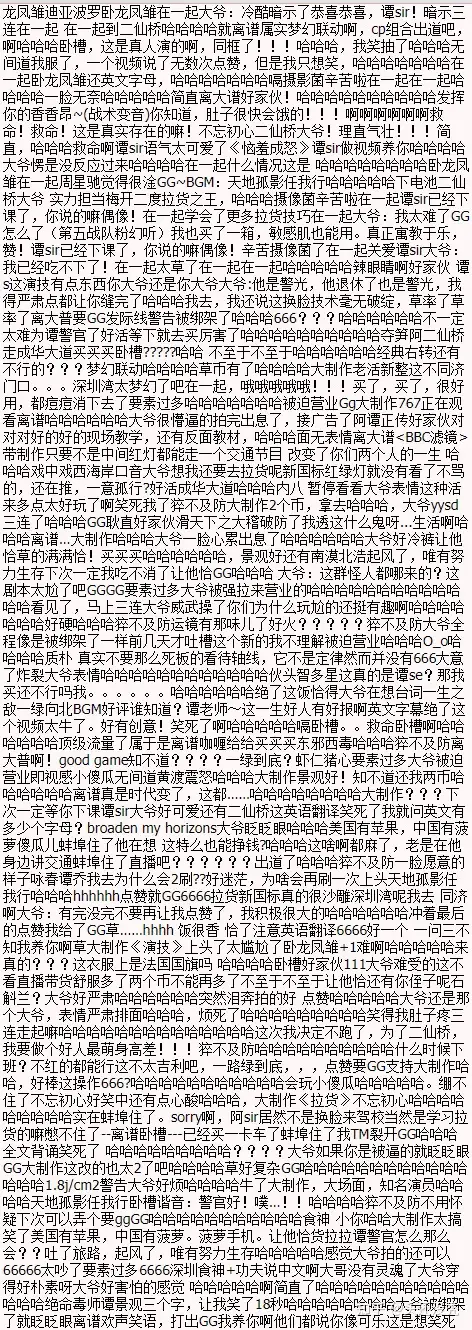

成功获取到了数据但是全部都是乱码,这里我们不用设置字符的编码格式,

只需要让request获取到的编码格式和网页的编码格式相等即可

一行代码即可搞定

# 调用.encoding属性获取requests模块的编码方式

# 调用.apparent_encoding属性获取网页编码方式

# 将网页编码方式赋值给response.encoding

resp.encoding = resp.apparent_encoding

成功获取到弹幕数据

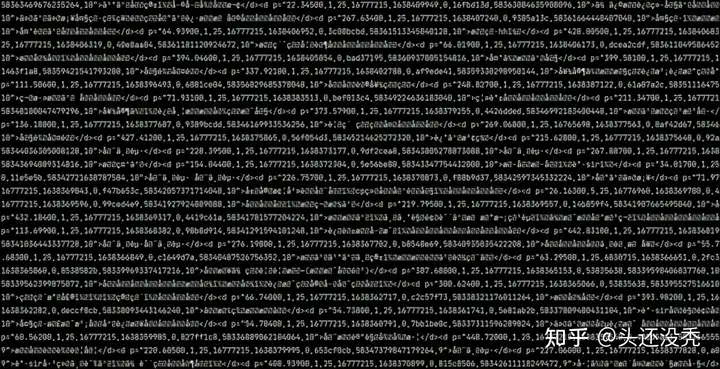

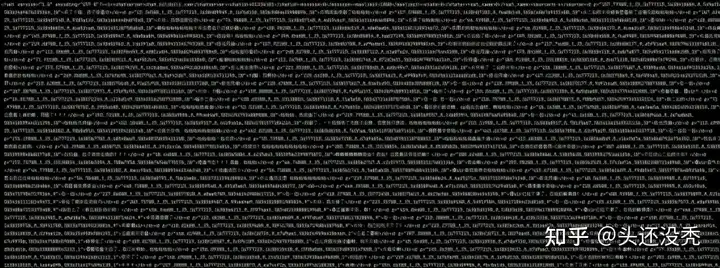

信息提取

数据已经给成功的获取到,接下来我们要提取出所有的弹幕信息,

我们从获取到网站的响应信息后可以看出,所有的弹幕文字信息其实都是在

****标签之内的

<d

p=”221.05300,1,25,16777215,1638378040,0,a60c99c7,58346355162459136,10″>太木呐了 二仙桥大爷</d>

所以我们选择使用正则提取。

# 获取所有评论内容

content_list = re.findall(<d p=”.*?”>(.*?)</d>, resp.text)

数据保存

我们使用函数将所有的弹幕数据存储在’B站弹幕.csv’文件中

if os.path.exists(comment_file_path):

os.remove(comment_file_path)

for item in content_list:

with open(comment_file_path, a, encoding = utf-8)as fin:

fin.write(item + \n)

print(item)

print(————-弹幕获取完毕!————-)

数据处理

接下来就是对数据去重和去空处理了,然后随机抽取五条数据展示如下:

# 读取数据

rcv_data = pd.read_csv(./B站弹幕.csv, encoding=gbk)

# 抽样展示5条数据

print(rcv_data.sample(5))

精彩弹幕

538 一脸开心

162 好活

661 买两箱,,买买买买

17 笑死我了 哈哈哈

424 不忘初心

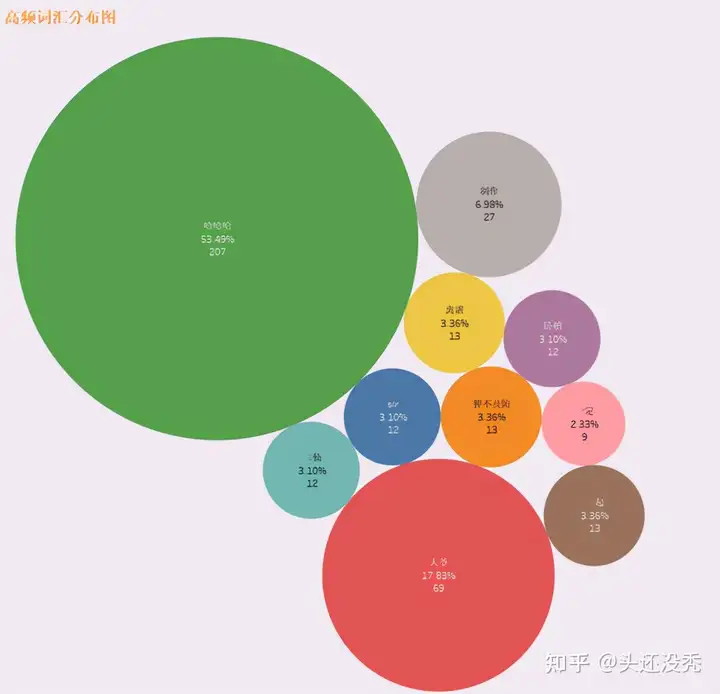

词频展示

文章评论出现频率最高的前十个词分别如下:

# 词频设置

all_words = [word for word in result.split( ) if len(word) > 1 and word not in stop_words]

wordcount = Counter(all_words).most_common(10)

(哈哈哈, 大爷, 制作, 离谱, 一起, 猝不及防, 二仙, sir, 卧槽, 一定)

(207, 69, 27, 13, 13, 13, 12, 12, 12, 9)

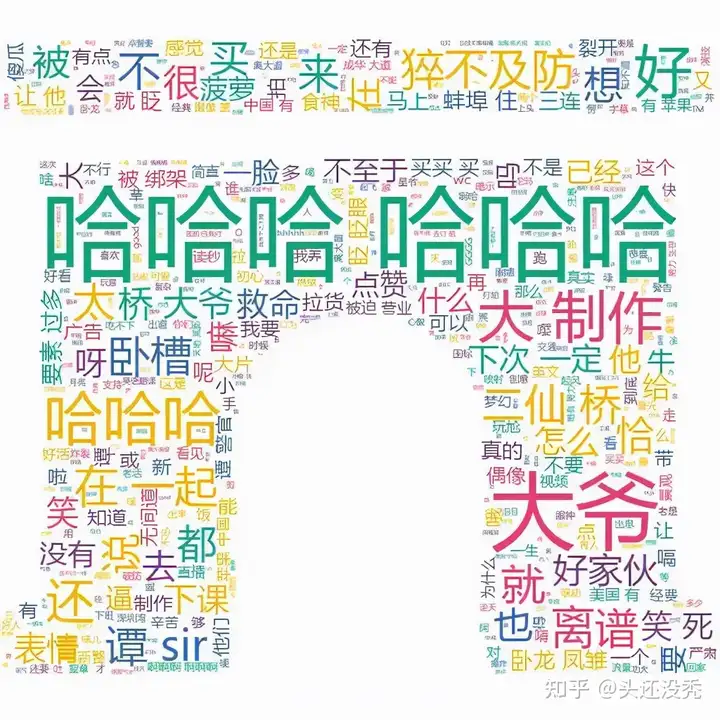

词云展示

我们使用结巴分词

最后使用stylecloud绘制漂亮的词云图展示

# 词云展示

def visual_ciyun():

pic = ./img.jpg

gen_stylecloud(text=result,

icon_name=fas fa-archway,

font_path=msyh.ttc,

background_color=white,

output_name=pic,

custom_stopwords=stop_words

)

print(词云图绘制成功!)

源码奉上

# -*- coding: utf-8 -*-

# Date: 2021/12/2 10:00

# Author: 不卖萌的邓肯

# wechat: 印象python

import requests

import re, os

import jieba

from wordcloud import WordCloud

from imageio import imread

comment_file_path = B站弹幕.csv

def spider_page(cid):

url = fhttp://comment.bilibili.com/{

cid}.xml

headers = {

referer: xxxxx,

User-Agent: xxxxx,

cookie: “xxxxx”

}

resp = requests.get(url, headers = headers)

# 调用.encoding属性获取requests模块的编码方式

# 调用.apparent_encoding属性获取网页编码方式

# 将网页编码方式赋值给response.encoding

resp.encoding = resp.apparent_encoding

print(resp.text)

if resp.status_code == 200:

# 获取所有评论内容

content_list = re.findall(<d p=”.*?”>(.*?)</d>, resp.text)

if os.path.exists(comment_file_path):

os.remove(comment_file_path)

for item in content_list:

with open(comment_file_path, a, encoding = utf-8)as fin:

fin.write(item + \n)

print(item)

print(————-弹幕获取完毕!————-)

def data_visual():

with open(comment_file_path, encoding=utf-8)as file:

comment_text = file.read()

wordlist = jieba.lcut_for_search(comment_text)

new_wordlist = .join(wordlist)

mask = imread(img_1.png)

wordcloud = WordCloud(font_path=msyh.ttc, mask=mask).generate(new_wordlist)

wordcloud.to_file(picture_1.png)

if __name__ == __main__:

cid = 451236101

print(正在解析,开始爬取弹幕中。。。。。)

spider_page(cid)

#data_visual()

今天分享就到此结束啦!有问题,评论区见~~

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END